Proxmox VE (https://www.proxmox.com/en/) è un sistema di virtualiazzazione open source basata sulla distribuzione Debian GNU / Linux 64 bit e utilizza un kernel Linux specificamente personalizzato.

Il codice sorgente di Proxmox VE viene rilasciato sotto la GNU Affero General Public License, versione 3 (GNU AGPL, v3). Ciò significa che è possibile esaminare in qualsiasi momento il codice sorgente o contribuire al progetto stesso.

L’utilizzo di software open source con licenza GNU AGPL, v3 garantisce un accesso completo a tutte le funzionalità, nonché un elevato livello di affidabilità e sicurezza

Proxmox VE è una piattaforma completa per la virtualizzazione aziendale, che integra perfettamente le macchine virtuali KVM hypervisor e LXC container, e gestisce facilmente i cluster di alta disponibilità HA e gli strumenti di ripristino di emergenza tramite l'interfaccia di gestione web.

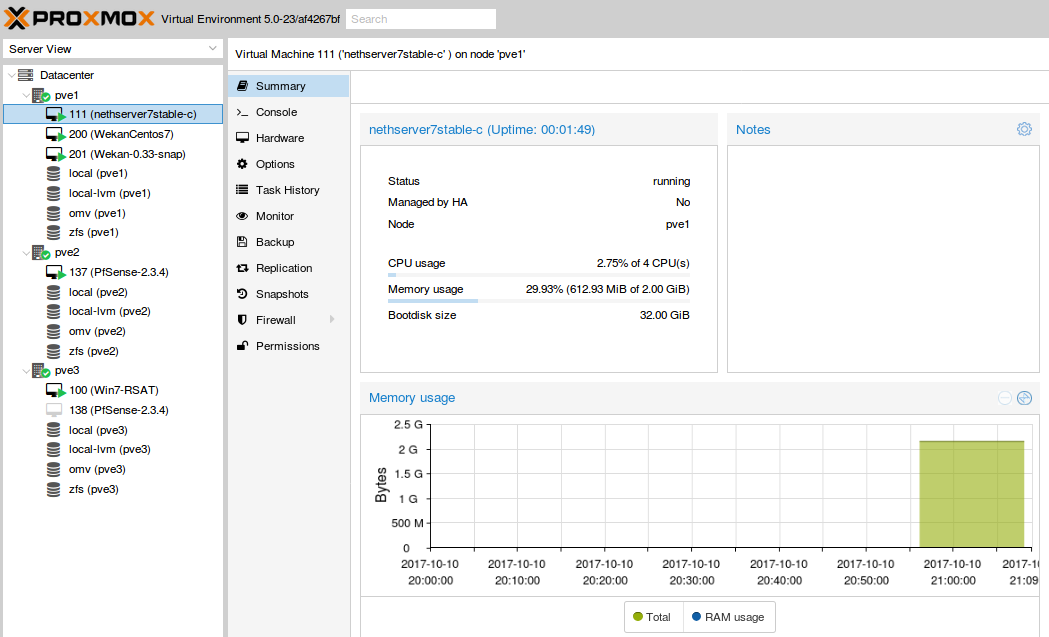

Nelle ultime settimane abbiamo configurato il Datacenter della nostra associazione all'interno del laboratorio, con il sistema di virtualizzazione open source Proxmox vers. 5 creando una infrastruttura Cluster in HA.

L'infrastruttura Cluster in HA (High Availability) è organizzata nel seguente modo:

- Nr.1 Server rack 16 GB di ram Pve1-Proxmox

- Nr.1 Server rack 16 GB di ram Pve2-Proxmox

- Nr.1 Server rack 8 GB di ram Pve3-Proxmox

- Nr.1 Server rack 4 GB di ram NAS OpenMediaVault 2 HD da 1 TB in RAID1 condivisione NFS per lo storage degli hard disk virtuali del cluster e dei backup automatizzati.

Sul cluster abbiamo implementato un DC (domain controller) con le seguenti virtual machine:

- VM- Nethserver vers. 7.3 (dominio)

- VM- (RSAT per controllo dominio e prove con clients vari)

- VM-OpenSuse Desktop (già in dominio)

- VM-Server Fedora (gestione Docker)

- VM-Centos 7

Oltre all’infrastruttura cluster abbiamo configurato un singolo server per gestire altre virtual machine:

- Nr. 1 server proxmox (HP proliant 150), con a bordo VM PfSense e VM Zabbix.

Configurazione di Proxmox VE 5 In Multiple Node Cluster

- Nr.3 Proxmox server

pve1

IP : 192.168.1.114

FQDN : pve1.riminilug.lab

SSH port: 22

pve2

IP: 192.168.1.115

FQDN : pve2.riminilug.lab

SSH port: 22

pve3

IP : 192.168.1.116

FQDN : pve3.riminilug.lab

SSH port : 22

ssh root@192.168.1.114

nano /etc/hosts

Aggiungere le seguenti righe

192.168.1.115 pve2.riminilug.lab pve2 pvelocalhost

192.168.1.116 pve3.riminilug.lab pve3 pvelocalhost

reboot

ssh root@192.168.1.115

nano /etc/hosts

Aggiungere le seguenti righe

192.168.1.114 pve1.riminilug.lab pve1 pvelocalhost

192.168.1.116 pve3.riminilug.lab pve3 pvelocalhost

reboot

ssh root@192.168.1.116

nano /etc/hosts

Aggiungere le seguenti righe

192.168.1.114 pve1.riminilug.lab pve1 pvelocalhost

192.168.1.115 pve2.riminilug.lab pve2 pvelocalhost

reboot

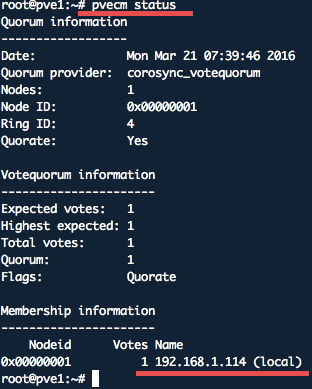

ssh root@192.168.1.114

pvecm create mynode (mynode è il nome del cluster a piacere)

Result:

Corosync Cluster Engine Authentication key generator.

Gathering 1024 bits for key from /dev/urandom.

Writing corosync key to /etc/corosync/authkey.

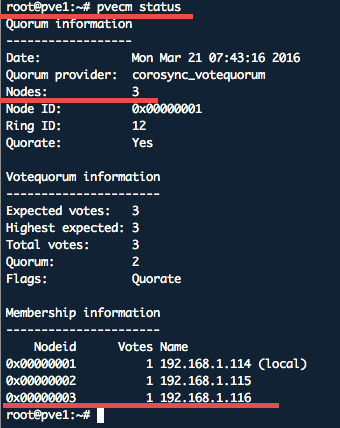

pvecm status

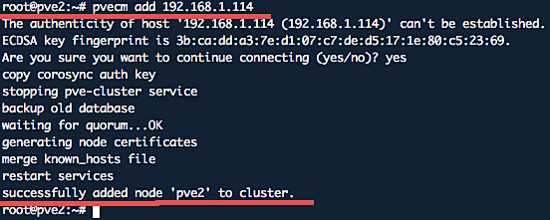

Aggiungere pve2 e pve3 in cluster

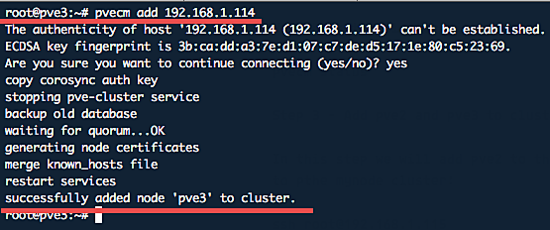

ssh root@192.168.1.115

pvecm add 192.168.1.114

ssh root@192.168.1.116

pvecm add 192.168.1.114

pvecm status

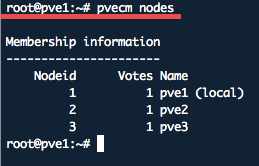

Per visualizzare i nodi:

pvecm nodes

Con l’implementazione del cluster, abbiamo verificato come il sistema in HA sia in grado di bilanciare il carico di lavoro su diversi host distribuito su 3 nodi, per aumentare la disponibilità delle macchine virtuali (HA).

Abbiamo testato l’alta affidabilità (HA) delle macchine virtuali, simulando alternativamente il failover dei 3 nodi del cluster e, le macchine virtuali sono rimaste sempre on line migrando in modo automatico sul nodo funzionante con priorità più alta.

All’interno del cluster è possibile eseguire anche la migrazione manuale delle macchine virtuali in tempo reale (live).

Matteo Cecchini

Giuseppe Ferrara